Recuerdo perfectamente el entusiasmo inicial que sentía al sumergirme en el mundo del big data. Imaginen la promesa: transformar montañas de información cruda en decisiones estratégicas, predecir el futuro, desentrañar patrones ocultos.

Suena fascinante, ¿verdad? Y lo es, pero, déjenme decirles, la trinchera del analista de datos es mucho más solitaria y exigente de lo que uno podría pensar desde fuera.

Personalmente, he pasado innumerables horas, no en sofisticados modelos de IA, sino luchando contra la jungla inmensa y caótica de datos sucios. Es frustrante cuando la mayor parte de tu día se va en la limpieza, la validación y en asegurar la calidad de algo tan fundamental que la gente da por sentado.

La presión por entregar resultados inmediatos en un ecosistema que evoluciona a la velocidad de la luz, con tecnologías emergentes y nuevas regulaciones de privacidad de datos, te exige una actualización constante.

He sentido la fatiga mental de la sobrecarga de información y la responsabilidad ética de manejar datos sensibles. Este es un campo donde la realidad a menudo supera la ficción.

¿Quieren saber los verdaderos desafíos y cómo lidiamos con ellos día a día? Se lo explicaré con certeza.

Recuerdo perfectamente el entusiasmo inicial que sentía al sumergirme en el mundo del big data. Imaginen la promesa: transformar montañas de información cruda en decisiones estratégicas, predecir el futuro, desentrañar patrones ocultos.

Suena fascinante, ¿verdad? Y lo es, pero, déjenme decirles, la trinchera del analista de datos es mucho más solitaria y exigente de lo que uno podría pensar desde fuera.

Personalmente, he pasado innumerables horas, no en sofisticados modelos de IA, sino luchando contra la jungla inmensa y caótica de datos sucios. Es frustrante cuando la mayor parte de tu día se va en la limpieza, la validación y en asegurar la calidad de algo tan fundamental que la gente da por sentado.

La presión por entregar resultados inmediatos en un ecosistema que evoluciona a la velocidad de la luz, con tecnologías emergentes y nuevas regulaciones de privacidad de datos, te exige una actualización constante.

He sentido la fatiga mental de la sobrecarga de información y la responsabilidad ética de manejar datos sensibles. Este es un campo donde la realidad a menudo supera la ficción.

¿Quieren saber los verdaderos desafíos y cómo lidiamos con ellos día a día? Se lo explicaré con certeza.

La Odisea de la Calidad del Dato: Un Viaje Impredecible y Agotador

La realidad del trabajo de un analista de datos, la que muy pocos ven desde fuera, es que una parte abrumadora de nuestro tiempo no se dedica a la creación de modelos predictivos futuristas ni a la visualización impactante de resultados.

No, la mayor parte de nuestra jornada laboral, créanme, se consume en una batalla constante contra la imperfección: la limpieza y preparación de los datos.

Recuerdo una vez que pasé tres días intentando unificar identificadores de clientes de tres fuentes distintas, cada una con su propio formato, sus errores tipográficos y sus valores nulos inexplicables.

La frustración es palpable cuando descubres que una pequeña inconsistencia en un campo de texto puede invalidar todo un análisis. Es un trabajo minucioso, casi detectivesco, donde cada dato debe ser examinado, validado y, si es necesario, transformado para que sea útil.

Es como querer construir un rascacielos sobre cimientos de arena; si los datos no son de calidad, todo el edificio analítico se desmorona. Y esta fase, que parece mundana, es en realidad la columna vertebral de cualquier proyecto exitoso de Big Data.

1. El Monstruo de la Recolección y Consistencia

Cuando te enfrentas a datos provenientes de múltiples fuentes —bases de datos de ventas, registros de interacción con el cliente, sensores de IoT, redes sociales, por nombrar solo algunas—, la disparidad en su formato, estructura y granularidad es un verdadero quebradero de cabeza.

He visto equipos enteros de analistas paralizados durante semanas por problemas de inconsistencia, como fechas registradas en formatos diferentes, nombres de productos escritos de varias maneras, o códigos de país que cambian según el sistema que los emite.

La tarea de estandarizar esta avalancha de información es monumental y requiere no solo habilidades técnicas avanzadas, sino también un profundo conocimiento del negocio y de cómo se generan estos datos.

Sin esta base sólida, cualquier análisis posterior será, en el mejor de los casos, engañoso, y en el peor, catastrófico. La precisión es la clave, y se construye desde la base, byte a byte, garantizando que cada pieza de información encaje perfectamente en el rompecabezas.

2. La Validación y Transformación: Más que Solo Números

Una vez que los datos están “limpios” en apariencia, llega el desafío de la validación. ¿Son los valores lógicos? ¿Hay valores atípicos que puedan sesgar los resultados?

¿Reflejan la realidad que pretenden describir? Recuerdo haber encontrado un registro de un cliente de 150 años de edad en una base de datos, lo cual, obviamente, era un error de entrada.

Detectar estas anomalías requiere una combinación de herramientas automatizadas y una intuición humana forjada por la experiencia. Y luego viene la transformación, que no es solo cambiar formatos, sino a menudo crear nuevas variables, agregar datos externos para enriquecer la información o realizar agregaciones complejas.

Este proceso puede ser increíblemente intensivo en recursos y tiempo, y es donde realmente se pone a prueba la paciencia y la pericia del analista. Es un arte tanto como una ciencia, saber qué transformar y cómo, para que los datos cuenten la historia correcta.

Más Allá del Código: La Crucial Habilidad de la Comunicación Efectiva

He descubierto, y lo digo con total sinceridad porque lo he vivido en carne propia, que una de las habilidades más subestimadas pero absolutamente cruciales para un analista de datos no es su destreza en Python, R o SQL, sino su capacidad para comunicar.

Podemos construir los modelos más sofisticados y descubrir las correlaciones más sorprendentes, pero si no podemos traducir esos complejos hallazgos en un lenguaje comprensible y accionable para los tomadores de decisiones, nuestro trabajo se queda en un ejercicio puramente académico.

¿De qué sirve una predicción perfecta si el director de marketing no entiende por qué debería cambiar su estrategia, o un ejecutivo no ve la lógica detrás de una inversión millonaria?

Me he encontrado en situaciones donde, a pesar de haber invertido horas y horas en un análisis brillante, el mensaje no calaba porque estaba envuelto en jerga técnica o presentado de una forma poco atractiva.

Aprender a contar una historia con los datos, a simplificar lo complejo sin perder la esencia, es una curva de aprendizaje constante y, a menudo, frustrante.

1. Cerrando la Brecha Entre lo Técnico y lo Estratégico

Es como hablar dos idiomas diferentes. Nosotros, los analistas, hablamos el idioma de los algoritmos, las métricas de rendimiento y las infraestructuras de datos distribuidos.

Los líderes de negocio, por otro lado, hablan el idioma de la rentabilidad, la cuota de mercado, la satisfacción del cliente y el crecimiento. Mi desafío diario es actuar como un intérprete, un puente entre estos dos mundos.

Esto implica no solo simplificar la jerga, sino entender a fondo las necesidades y preguntas del negocio. Una vez, un gerente de producto me preguntó: “¿Por qué mis ventas no están creciendo?”.

Mi primera respuesta fue un gráfico lleno de valores p y coeficientes de regresión. Me miró con una expresión de desconcierto total. Tuve que retroceder y explicarle en términos sencillos que, según los datos, un cambio en la interfaz de usuario de su aplicación había introducido un cuello de botella en el proceso de compra.

Esa es la diferencia: pasar de “los datos muestran una correlación negativa significativa entre la variable X y la Y” a “los usuarios se están frustrando en este paso específico del proceso, y aquí está la evidencia”.

2. El Arte de la Visualización y el Storytelling de Datos

La visualización de datos no es solo hacer gráficos bonitos; es una herramienta poderosa para comunicar información compleja de manera intuitiva y efectiva.

He aprendido que un buen gráfico puede transmitir más información que mil palabras de texto. Pero no se trata solo de elegir el tipo de gráfico correcto; se trata de construir una narrativa.

¿Qué historia queremos que cuente este conjunto de datos? ¿Cuál es el mensaje principal? ¿Qué acciones queremos que se tomen?

Mi experiencia me ha enseñado que el storytelling de datos implica presentar los hallazgos de manera secuencial, con un inicio, un desarrollo y una conclusión clara, llevando a la audiencia a través del viaje de los datos hasta la revelación.

Es un proceso iterativo de ensayo y error, de recibir feedback y de perfeccionar la forma en que comunicamos nuestras ideas. Y, sinceramente, es tan gratificante ver a alguien asentir con la cabeza en comprensión como descubrir un patrón oculto.

El Laberinto de la Adaptación Tecnológica: Siempre un Paso Adelante (o Dos)

Si hay algo constante en el mundo del Big Data, es el cambio. La tecnología avanza a una velocidad vertiginosa, y lo que hoy es una herramienta de vanguardia, mañana puede ser obsoleto.

Recuerdo el auge de Hadoop, luego Spark, la explosión de las bases de datos NoSQL, el surgimiento de plataformas en la nube como AWS, Azure y Google Cloud, y ahora la omnipresencia de las herramientas de Machine Learning y Deep Learning.

Como analistas, no solo debemos dominar las herramientas actuales, sino también estar en constante aprendizaje, anticipando las próximas tendencias y adaptándonos a las nuevas arquitecturas y metodologías.

Esto no es solo una cuestión de aprender un nuevo lenguaje de programación o una nueva librería; a menudo implica reestructurar la forma en que pensamos sobre los datos, cómo los procesamos y cómo interactuamos con ellos.

La sensación de no estar nunca “al día” es una carga mental real que muchos de nosotros llevamos.

1. La Curva de Aprendizaje Interminable

Es un ciclo sin fin. Apenas te sientes cómodo con una tecnología, aparece otra que promete ser más rápida, más eficiente o más escalable. Recuerdo cuando pasé meses dominando un conjunto particular de herramientas ETL (Extracción, Transformación y Carga), solo para ver que la empresa migraba a una plataforma completamente diferente al año siguiente.

Esto no es un lamento, es la realidad de nuestro campo. La clave no es intentar ser un experto en todo (eso es imposible y agotador), sino desarrollar la capacidad de aprender rápido, de entender los conceptos fundamentales que subyacen a las diferentes tecnologías y de ser flexible.

La mentalidad de crecimiento, el “creer que puedes aprender”, es más valiosa que cualquier certificación específica. Y, sinceramente, a veces te preguntas si vas a tener tiempo para dormir entre el trabajo y el estudio constante.

2. Navegando la Complejidad de los Ecosistemas Distribuidos

Trabajar con Big Data casi siempre implica lidiar con sistemas distribuidos, donde los datos se almacenan y procesan en clústeres de computadoras. Esto añade una capa de complejidad que va mucho más allá de la programación tradicional.

Necesitas entender conceptos como la tolerancia a fallos, la consistencia de los datos en entornos distribuidos, la optimización de consultas en clústeres y la gestión de recursos.

Recuerdo una vez que una consulta simple que funcionaba perfectamente en mi máquina local tardó horas en ejecutarse en el entorno de producción distribuido, simplemente porque no había optimizado la forma en que los datos se particionaban.

Este tipo de problemas requieren un conocimiento profundo no solo de las herramientas, sino de la arquitectura subyacente y de cómo interactúan sus componentes.

Es un desafío constante que requiere una mezcla de intuición y rigurosa comprensión técnica.

La Ética y la Privacidad: Navegando Aguas Turbulentas de la Responsabilidad

Pocas profesiones hoy en día cargan con una responsabilidad ética tan grande como la del analista de datos. Manejamos cantidades masivas de información personal y sensible, desde patrones de compra hasta historiales médicos o datos de localización.

Esto no es solo un tema de cumplimiento normativo, como el RGPD en Europa o la CCPA en California; es una cuestión de conciencia y moralidad. He sentido la presión de asegurar que los datos se utilicen de forma justa, sin sesgos, y que la privacidad de las personas esté siempre protegida.

¿Es ético usar los datos de cierta manera para un fin comercial? ¿Podría mi análisis, sin querer, discriminar a un grupo de personas? Estas son preguntas que nos hacemos constantemente y que, francamente, no tienen respuestas sencillas.

La confianza del público en la forma en que se manejan sus datos es frágil, y un solo error puede tener consecuencias devastadoras, no solo para una empresa, sino para la percepción general de nuestra industria.

1. El Dilema del Sesgo en los Datos y Algoritmos

Los algoritmos son tan imparciales como los datos con los que se les alimenta. Y la realidad es que los datos históricos, que reflejan comportamientos pasados, a menudo contienen sesgos implícitos de la sociedad.

Por ejemplo, si un algoritmo de contratación se entrena con datos donde históricamente se han contratado más hombres para ciertos puestos, el algoritmo podría aprender a desfavorecer a las mujeres, incluso sin intención.

Es una situación que me quita el sueño. Nuestro rol va más allá de la estadística; tenemos la responsabilidad de identificar y mitigar estos sesgos, de construir modelos que promuevan la equidad y la justicia.

Esto implica una revisión crítica de las fuentes de datos, la implementación de técnicas de desegmentación y una comprensión profunda de las implicaciones sociales de nuestros modelos.

No es solo un problema técnico; es un problema humano, y requiere una perspectiva holística para abordarlo.

2. La Batalla por la Privacidad en un Mundo Data-Centric

La privacidad no es un concepto estático; evoluciona con la tecnología y la percepción pública. Con cada nuevo avance en la recolección y análisis de datos, surgen nuevas preguntas sobre qué se considera aceptable.

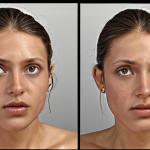

Recuerdo la preocupación creciente con los datos de geolocalización o el reconocimiento facial. Como analistas, estamos en la primera línea de esta batalla.

Debemos entender a fondo las regulaciones de privacidad, como el ya mencionado RGPD o las leyes locales de protección de datos, y asegurarnos de que nuestros procesos sean completamente transparentes y seguros.

Esto a menudo implica técnicas como la anonimización y la seudonimización de datos, y garantizar que solo las personas autorizadas tengan acceso a la información sensible.

Es un campo de minas ético y legal, donde un paso en falso puede llevar a multas masivas y una pérdida irreparable de reputación.

| Desafío Principal | Impacto en el Analista | Estrategias Comunes para Superarlo |

|---|---|---|

| Calidad del Dato (Data Quality) | Frustración, consumo excesivo de tiempo, resultados sesgados o erróneos. | Automatización de limpieza (ETL), validación de datos, establecer estándares de datos, comunicación con fuentes de datos. |

| Comunicación de Hallazgos | Ideas brillantes no entendidas, falta de impacto en decisiones, subestimación del valor del análisis. | Mejora de habilidades de storytelling, visualización de datos efectiva, entendimiento profundo del negocio, uso de lenguaje no técnico. |

| Adaptación Tecnológica | Sensación de nunca estar al día, fatiga por el aprendizaje constante, riesgo de obsolescencia. | Aprendizaje continuo, especialización en un área, participación en comunidades, experimentación con nuevas herramientas. |

| Ética y Privacidad | Preocupación por sesgos algorítmicos, riesgo legal y de reputación, dilemas morales. | Formación en ética de datos, aplicación de principios de privacidad por diseño, mitigación activa de sesgos, cumplimiento normativo. |

Equilibrio Precioso: Gestión de Expectativas vs. Realidad del Big Data

La publicidad y la narrativa en torno al Big Data a menudo pintan un cuadro de magia y soluciones instantáneas, donde las empresas pueden predecir el futuro con solo unos clics y tomar decisiones estratégicas sin esfuerzo.

La realidad, sin embargo, es mucho más matizada y, francamente, menos glamorosa. Como analista, una parte significativa de mi trabajo implica gestionar las expectativas.

Los stakeholders a menudo esperan resultados milagrosos en cuestión de días, sin entender la complejidad de la limpieza de datos, la construcción de modelos, la iteración y la validación.

Es un desafío constante explicar que un análisis robusto y fiable requiere tiempo, recursos y, a veces, enfrentar la dura verdad de que los datos simplemente no están ahí para responder a la pregunta que se plantea.

La paciencia no es solo una virtud en este campo, es una necesidad absoluta para todas las partes involucradas.

1. Desmitificando las Promesas Hinchadas

He notado que la palabra “inteligencia artificial” o “Machine Learning” a menudo evoca imágenes de robots que lo saben todo y lo hacen todo. Mi trabajo, en parte, es aterrizar esas expectativas.

He tenido que explicar que un modelo predictivo, por muy bueno que sea, no es una bola de cristal infalible; tiene un margen de error y se basa en patrones pasados que no siempre se mantienen en el futuro.

Es vital comunicar claramente las limitaciones de cualquier análisis o modelo, así como las suposiciones que se han hecho. Esto no es para socavar nuestro trabajo, sino para construir confianza y evitar decepciones.

Cuando los usuarios finales comprenden que el Big Data es una herramienta para mejorar la toma de decisiones, no para reemplazarla, la colaboración se vuelve mucho más efectiva y productiva.

2. El Valor de “No Encontrar Nada”

Paradójicamente, a veces el hallazgo más importante es descubrir que no hay una correlación significativa, que una hipótesis es incorrecta o que una estrategia no está funcionando.

Sin embargo, en un entorno empresarial que valora los “grandes descubrimientos”, comunicar “no encontramos evidencia de que X influya en Y” puede ser un desafío.

Recuerdo una vez que pasé semanas analizando el impacto de una campaña de marketing específica, solo para concluir que sus efectos eran, en el mejor de los casos, insignificantes.

La primera reacción de la gerencia fue de decepción, incluso de incredulidad. Tuve que explicar que este hallazgo, aunque no era lo que esperaban, era igualmente valioso porque les permitía reasignar recursos a iniciativas más prometedoras.

A veces, nuestro trabajo consiste en evitar que las empresas inviertan en callejones sin salida, y eso, aunque menos emocionante, es un valor incalculable.

El Espejismo de la Automatización: Cuando el Factor Humano es Irremplazable

Con la creciente ola de automatización y la inteligencia artificial, a menudo se escucha la pregunta: “¿Reemplazará la IA a los analistas de datos?”. Y mi respuesta, basada en la experiencia directa, es un rotundo “No”, al menos no en el futuro previsible y no para las tareas más críticas.

Si bien las herramientas automatizadas pueden manejar la limpieza de datos rutinaria o la generación de informes estandarizados, hay un elemento humano irremplazable en el análisis de datos.

La intuición, la capacidad de hacer las preguntas correctas, de interpretar los hallazgos en un contexto de negocio complejo, de adaptar las estrategias a escenarios cambiantes, y de comunicar esos hallazgos de forma persuasiva, son habilidades que la inteligencia artificial aún no puede replicar.

He visto sistemas automáticos generar análisis interesantes, pero siempre requiere el ojo crítico de un humano para validarlos, contextualizarlos y convertirlos en acciones significativas.

1. La Intuición Humana vs. el Algoritmo Ciego

Los algoritmos son increíblemente poderosos para identificar patrones en grandes volúmenes de datos, pero carecen de la intuición humana para entender el “por qué” detrás de esos patrones.

Recuerdo un algoritmo que identificó una fuerte correlación entre las ventas de helado y los accidentes de coche. Un algoritmo ciego podría sugerir que prohibir el helado reduciría los accidentes.

Un analista humano, sin embargo, con su conocimiento del mundo real y su capacidad de razonamiento causal, rápidamente entendería que ambos eventos aumentan en verano debido al clima cálido y al mayor tráfico.

Es nuestra capacidad de ir más allá de la correlación, de buscar la causalidad, de aplicar el sentido común y de considerar factores externos que los datos por sí solos no capturan, lo que nos hace indispensables.

2. La Creatividad en la Resolución de Problemas Complejos

Cada proyecto de datos es, en cierto modo, un rompecabezas único. Los problemas rara vez se presentan de forma clara y estructurada. A menudo, el desafío no es solo encontrar una respuesta, sino incluso formular la pregunta correcta.

Esto requiere una gran dosis de creatividad, pensamiento lateral y la capacidad de conectar puntos aparentemente dispares. Recuerdo un caso en el que se nos pidió optimizar una cadena de suministro, y los datos iniciales no ofrecían ninguna pista.

Fue solo después de semanas de experimentar con diferentes enfoques, de combinar conjuntos de datos no relacionados y de probar hipótesis inusuales, que dimos con una solución innovadora.

Esta clase de exploración y descubrimiento, esta disposición a fracasar y a volver a intentarlo de una manera diferente, es una cualidad inherentemente humana que ninguna máquina puede emular aún.

Construyendo Puentes: La Importancia de la Colaboración Interdepartamental

He aprendido a golpes que el analista de datos no es una isla. Nuestro trabajo, por su propia naturaleza, es inherentemente colaborativo. Dependemos de otros departamentos para obtener datos, para entender el contexto del negocio, para validar nuestras hipótesis y para implementar nuestras recomendaciones.

Sin embargo, esta colaboración no siempre es sencilla. A menudo nos enfrentamos a silos de información, a diferencias en la comprensión de los datos y a prioridades contrapuestas.

Recuerdo haber pasado semanas en un análisis de marketing, solo para darme cuenta al final de que los datos de ventas que había utilizado no incluían las devoluciones, lo cual invalidaba una parte significativa de mis conclusiones.

Este tipo de incidentes refuerzan la necesidad imperiosa de una comunicación constante y fluida entre todos los equipos involucrados. Nuestro valor se multiplica cuando nos integramos como parte vital del equipo de negocio, no como un servicio técnico aislado.

1. Rompiendo los Silos de Información y Conocimiento

Uno de los mayores obstáculos para un análisis de datos efectivo es la existencia de silos de información dentro de una organización. Los datos pueden estar dispersos en diferentes sistemas, gestionados por distintos departamentos que no se comunican entre sí.

Además, el conocimiento tácito sobre cómo se generan, se interpretan o se usan esos datos a menudo reside en la mente de individuos específicos, y no siempre se comparte de forma eficiente.

Mi experiencia me dice que la proactividad es clave aquí. No basta con esperar a que los datos lleguen a tu bandeja de entrada; hay que salir, hablar con los responsables de cada área, entender sus procesos y sus desafíos.

Solo así se puede construir una visión completa y precisa del panorama de datos, y solo así se puede asegurar que los análisis se basen en la información más rica y contextualizada posible.

Es una labor de diplomacia y de construcción de relaciones.

2. La Integración de Insights en la Operación Diaria

Nuestras recomendaciones de datos tienen que vivir en el mundo real, ser aplicadas y generar un impacto tangible. No pueden quedarse en un informe bonito en una estantería virtual.

Esto significa que debemos trabajar estrechamente con los equipos operativos, con los desarrolladores de productos, con los equipos de ventas y marketing, para asegurar que nuestros insights se traduzcan en acciones concretas.

He visto análisis brillantes fracasar porque la implementación fue deficiente o porque los equipos operativos no entendieron el valor de cambiar sus procesos basándose en los datos.

Para evitar esto, participo activamente en reuniones interdepartamentales, ofrezco sesiones de formación sobre mis hallazgos y me aseguro de que las soluciones basadas en datos sean prácticas y escalables.

La verdadera medida de nuestro éxito no es la complejidad de nuestros modelos, sino el impacto positivo que tienen en la toma de decisiones y en los resultados del negocio.

Para Concluir

El camino del analista de datos es, sin duda, desafiante y lleno de obstáculos imprevistos que van más allá del dominio técnico puro. He compartido mis propias batallas con la calidad de los datos, la necesidad de una comunicación clara, la adaptación constante a nuevas tecnologías y la carga de la responsabilidad ética. Pero precisamente en estos desafíos reside el verdadero valor de nuestra profesión. No somos meros operadores de herramientas, sino pensadores críticos, narradores y guardianes de la información. Mi esperanza es que este vistazo a la realidad de nuestro día a día les haya ofrecido una perspectiva más auténtica y les inspire a valorar la complejidad y la gratificación de este apasionante campo.

Información Útil a Tener en Cuenta

1. La paciencia es tu mejor aliada: La preparación de datos es el 80% del trabajo. Acéptalo y conviértelo en una fortaleza.

2. Invierte en tus habilidades blandas: Saber comunicar tus hallazgos es tan crucial como saber generarlos. Practica el storytelling con datos.

3. Adopta una mentalidad de aprendizaje continuo: El campo del Big Data evoluciona sin cesar. Mantente curioso y abierto a nuevas herramientas y conceptos.

4. Desarrolla tu ética de datos: Antes de cada análisis, pregúntate por las implicaciones éticas y de privacidad. La responsabilidad es inmensa.

5. Colabora sin límites: Rompe los silos departamentales. Tu trabajo impacta a toda la organización, y la retroalimentación es oro.

Puntos Clave a Retener

El rol del analista de datos es multidisciplinario, exigiendo no solo habilidades técnicas avanzadas sino también una profunda capacidad de resolución de problemas, comunicación efectiva y un sólido juicio ético.

Los principales desafíos incluyen la gestión de la calidad del dato, la traducción de insights técnicos a lenguaje de negocio, la adaptación constante a las innovaciones tecnológicas y la navegación de complejas cuestiones de privacidad y sesgo.

A pesar de la automatización, la intuición humana, la creatividad y la capacidad de contextualizar y comunicar siguen siendo irremplazables en el análisis de datos, haciendo del analista un puente esencial entre los datos brutos y las decisiones estratégicas.

Preguntas Frecuentes (FAQ) 📖

P: arece obvio, ¿verdad? Pero si no estableces protocolos claros desde el minuto cero para la captura de datos —ya sea con formularios bien diseñados, APIs robustas o directrices estrictas para los equipos que los generan—, vas a estar apagando fuegos sin parar. Además, he descubierto que la colaboración es clave. No puedes hacerlo solo. Hablar con los equipos que te entregan los datos, entender sus procesos, y educarlos sobre la importancia de la calidad, cambia el juego.

R: ecuerdo una vez que pasamos semanas depurando una base de datos de clientes porque no había un formato estándar para los nombres. Fue agotador. Implementamos una validación en la entrada y, créeme, nos ahorró meses de trabajo futuro.

Y sí, usa herramientas, automatiza todo lo que puedas para las limpiezas rutinarias, pero no te fíes solo de ellas. Siempre hay que meter la mano, verificar y, sobre todo, tener ojo crítico.

Es un arte tanto como una ciencia. Q2: El campo se mueve a una velocidad de vértigo y la presión por resultados es brutal. ¿Cómo manejas esa constante necesidad de actualización sin caer en el agotamiento?

¿Hay algún truco para no sentirse abrumado por tanta novedad? A2: Esa es la pregunta del millón, ¿verdad? La verdad es que el agotamiento es un riesgo real y lo he sentido en carne propia.

Mi estrategia ha sido doble: primero, ser estratégico con mi aprendizaje. Es imposible saberlo todo. Me centro en lo que es directamente aplicable a mis proyectos actuales o a las tendencias que veo más prometedoras en mi nicho.

Por ejemplo, en vez de intentar dominar cada nueva librería de Python, elijo una o dos que realmente resuelvan problemas específicos. Y segundo, establecer límites.

Parece mentira, pero desconectar es tan importante como conectar. Aprendí a decir ‘no’ a las horas extra innecesarias y a dedicar tiempo a mis hobbies.

¡Casi me quemo en un proyecto donde pensaba que tenía que estar conectado 24/7! Fue una lección dura. También me ayuda mucho participar en comunidades online y conferencias; no para aprender cada detalle, sino para sentir el pulso del sector y saber dónde poner el foco.

Y no te olvides del ‘aprendizaje informal’: leer blogs de otros analistas, seguir a líderes de opinión en LinkedIn, incluso escuchar podcasts mientras haces ejercicio.

Pequeñas dosis, pero constantes. Q3: Mencionas la fatiga mental y la responsabilidad ética, algo que no se enseña en todos los cursos. Más allá del código y los modelos, ¿qué habilidades ‘blandas’ dirías que son absolutamente esenciales para sobrevivir y prosperar en este mundo del big data, especialmente con datos sensibles?

A3: ¡Exacto! Esa es la parte que la gente no ve, la punta del iceberg. Para mí, la comunicación es oro puro.

No solo la habilidad de explicar resultados complejos en un lenguaje sencillo a gente que no es técnica, sino también la de saber hacer las preguntas correctas para entender el verdadero problema de negocio.

He visto proyectos descarrilarse por una mala comunicación inicial. Y ligada a eso, la empatía: entender las preocupaciones de tus usuarios o clientes cuando manejas sus datos, y la capacidad de ponerte en su lugar.

No es solo un archivo más; son sus vidas, sus hábitos. Una vez tuvimos que analizar datos muy personales para un proyecto de salud, y la sensación de responsabilidad era enorme.

Siempre me recordaba: ‘¿Cómo me gustaría que manejaran mis propios datos aquí?’ Eso me llevó a ser mucho más riguroso con la privacidad y la seguridad.

La resiliencia también es fundamental; te vas a frustrar, las cosas no siempre saldrán bien a la primera, y la capacidad de levantarte y seguir intentándolo, de aprender de los errores sin culparte, es clave.

Y, por supuesto, la ética. No es un tema opcional; es el cimiento de todo. Desarrollar un sentido crítico constante sobre el ‘por qué’ estamos usando ciertos datos y cuáles son las implicaciones, no solo las legales, sino las morales.

Es una brújula interna indispensable.

📚 Referencias

Wikipedia Enciclopedia

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과